数据中心的出现,是为了满足日益复杂的任务处理需求,而数据中心节能冷却系统的出现,又是为了解决数据中心的能耗和散热问题。如果将数据中心比作一个热源,为用户提供服务的过程中不断产生热量,那么数据中心节能冷却系统则是一个冰库,不断吸收和消化数据中心的热量,并在冷热均衡中提供持久稳定的能量输出。如果将数据中心比作威猛无比、无所不能的巨人,那数据中心节能冷却系统则是巨人的贴身护卫,为数据中心强大而又稳定的功能输出提供源源不断的支持。

“冷”“热”大PK

近两年来,数据中心出尽了风头。一方面,数据中心一改以往神秘莫测、难以接近的形象,纷纷转投亲民路线;另一方面,数据中心犹如阿罗多姿的女子正以各种各样的姿态向世人展示,这其中既有主打安全的铁山数据中心,也有超高密度的SuperNAP数据中心,更有海水数据中心。这些数据中心从不同角度,展现出令人拍案叫奇的先进技术和设计理念。

此外,还出现了一种集装箱数据中心。它采用了不同以往的数据中心建设方案,以标准化、模块化的方式在集装箱中进行数据中心的搭建。这种新型的集装箱数据中心,可以节省动辄成百上千平米的机房设施,它不受场地和时间限制,根据用户需要可以随时进行调配。

与此相关,不太为人所知的数据中心节能冷却系统也开始逐渐走入“寻常百姓家”。“魔高一尺道高一丈”,某种程度上说也能反映当今和未来数据中心发展历程所经历的坎坷之路。数据中心节能冷却系统是随着近年来数据中心的发展壮大而不断成熟。比如传统所采用的风冷精密空调系统、离心式水冷空调系统,正向更加节能和高效的地下溶洞、海水等自然制冷方式转变。

IDS和谷歌公司分别提出了DATAship和water-based datacenter海上数据中心架构。IDS的第一个船舶数据中心停靠在旧金山湾,它拥有多达1500架服务器的能力。IDS的设计特点是对地板进行冷却,利用APC的热通道密封系统隔离开数据中心的冷热空气。在循环冷却系统上也将使用IDS创新技术:使用船舶的双壳创建一个热交换。船体之间被用来储存燃料或石渣水,在闭合的空间内使冷盐水转换称淡盐水,并形成一个封闭的水冷却系统。

而谷歌的“water-based datacenter”将依靠海水和潮汐发电,同时利用海水的流动,对数据中心里的机器进行冷却。将数据中心设立在一艘或多艘停靠在水上的船上,通过自然水流运动采集能源,转换成为电能提供给数据中心使用,或者提供给冷却水泵用于冷却数据中心。

近年来,谷歌、IBM、思科、惠普、富士康、博科和微软等各大厂商,纷纷亮相旗下数据中心,向世人展示其雄厚的公司实力。这些数据中心形态各异、五花八门,既有建造在地下溶洞内的铁山数据中心,也有建造在海上的IDS DATAship数据中心,以及建造在水泥筒内的Clumeq数据中心。

众厂商数据中心齐亮相,一方面,这是各大IT和运营商展示其公司实力和技术创新之举,体现了各大公司在机房设计和散热方面的技术成果,也体现了网络设备的强大性能和可靠性。另一方面,众厂商纷纷展示数据中心,也是为了迎合整个市场发展的需要。

虽然不能很明确地指出谁是第一个“自揭其数据中心”的厂商,但可以肯定的是,目前展示数据中心的厂商之多、频度之快早已不是以前所能比拟的。尤其是自从Facebook推出开源数据中心架构之后,数据中心已经成为了广大媒体和读者的热点。比如,紧接着思科推出集装箱数据中心之后,博科也借助技术日向世人展示其位于硅谷的数据中心,而惠普也紧随其后,推出数据中心超级冷却系统。

另外一个不容忽视的是,各大厂商轮番上阵展示数据中心,也是为了顺应云计算和虚拟化的趋势、及早抢占市场制高点捕获人心的需要。云计算和虚拟化是当今和未来相当长时间内最热门的IT应用领域,数据中心在整个IT应用中又起着核心作用。在未来云计算和虚拟化市场上,需要借助新一代系统平台和服务理念,改造过去零星分散、资源浪费、效率低下的格局。如果数据中心还停留在过去的水平,势必满足不了未来市场需要,相应的技术厂商和服务商也就会面临被淘汰的命运。

文胸品牌品牌肛裂用什么药很好左旋肉碱有副作用吗去痘印怎样瘦腿有效眼霜哪个好精油保湿眼霜精油怎样瘦脸睫毛膏美白祛斑产品去黑头产品在宇宙哲学中,有热自然就有冷,这是亘古不变的真理,对于数据中心来说也同样如此。从数据中心出现的那一天开始,就伴随有相关节能冷却系统的出现。在我国,第一代计算机机房诞生于上世纪60年代初,中科院计算所计算机大楼及机房冷却系统也随着建立起来、当时为机房配置了集中制冷空调系统,虽然由于系统庞大、地板下通风管网纵横交错,使得系统风量分配调节很难达到平衡,机柜内热交换效率非常低,但也算是国内数据中心冷热之战的首轮交锋。

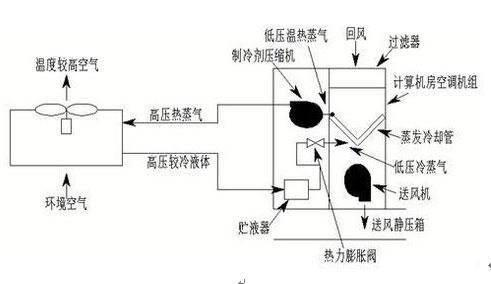

此前我们提到过的风冷精密空调冷却系统,就是专门应用与数据中心的传统冷却系统,它一般采用涡旋压缩机制冷(一般安装在精密空调内),能效比相对比较低,而且还存在安装困难的问题。

风冷精密空调冷却系统

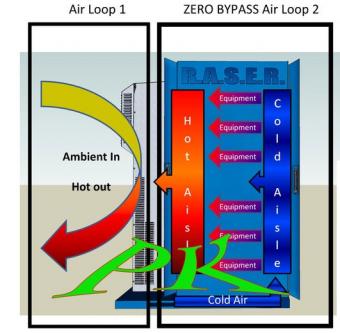

伴随冷却技术的发展,同时也是为了更好地满足数据中心散热和节能需要,出现了现代冷却系统。现代冷却系统以模块化为特点,尤其是美国APC公司开发出的模块化机柜级(In-row)冷却系统最具代表性。它采用了模块化组合方式,使得每个模块可跟着机柜走、又围着机柜转的制冷系统。该模块化机柜级冷却系统不仅能满足高密度机柜冷却需要,同时也能满足大中型数据中心散热需要。

新安装好的APC In-Row 冷却单元

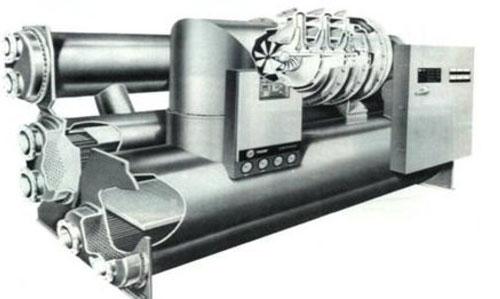

目前新一代数据中心采用的冷却系统中,比较常见的还有离心式水冷空调系统,这种冷却系统的特点是制冷量大并且整个系统的能效比高(一般能效比在3到6之间)。

离心式水冷空调系统

而本文中所提及的海水数据中心、地下溶洞数据中心,都采用了结合现代冷却工艺和自然冷却源的方式进行,这种方式在满足冷却需要的同时,更能实现节能减排的目标。

矿物油冷却系统打破传统格局

高热密度制冷专家Green Revolution Cooling提出了一种颠覆式的冷却系统方案。该冷却系统要求将机柜平衡放倒在地,然后倒入250 加仑的电介质液体,将服务器垂直插入周围的槽体内,并由连接到商用蒸发式冷却塔上的热交换器来控制液体的温度。该液体容器是由3英寸厚的角钢制成,每个容器里都装有液体液位检测传感器,冷却液体水位反生变化时会立即报警。

内含矿物油的冷却系统

根据介绍,该液体冷方案却主要用于高性能计算(HPC)和其他应用的高密度部署,主要针对难以管理的空气冷却问题。而对于液体冷却的安全问题该公司负责人表示,矿物油作为浸泡液体并没有危险性,矿物油的导热性和水一样,但不没有电荷。

冷与热,守与攻,将是数据中心过去、现在和未来的发展常态。在考虑部署数据中心的时候,都不能忽视这两者中的任何一个 。

随着人们环保意识的增强,通过技术手段获得更加高效的能源使用效率,使数据中心向“绿色”转型。这是数据中心发展是必然,也是符合云计算和未来业务处理的需要。

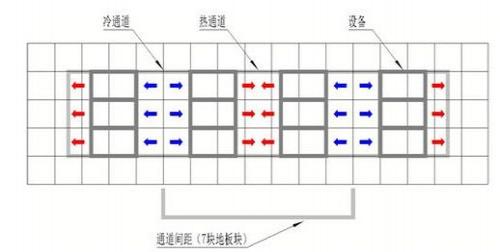

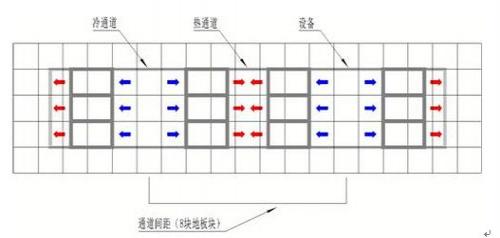

适用于单个机柜的冷热通道分布

适用于高密度机柜的冷热通道分布

因此,数据中心当下兴起来的热,既是数据中心本身所产生的热量,也是各大数据中心厂商掀起来的你追我赶之势。而数据中心的稳步健康发展,自然也离不开高效、稳定的节能冷却系统。“热”与“冷”之间的大PK,表面上是一种技术之争,实质上却是数据中心健康发展的优化平衡。未来的数据中心,势必是“热”与“冷”的齐头并进。